【UE5】Android环境使用脸捕

最近项目上对虚拟人的脸捕、动捕、手捕等有所涉及,于是就想自己搞一套来玩玩,动捕手捕没有设备于是只好向脸捕下手了,现在世面上主流的也是效果最好的UE4脸捕方案是使用iphoneX以上的版本的iphone手机提供的深度摄像头加LiveLinkFace App可以很便捷的实现手机摄像头抓取面部特征并连接到UE实时提供给数字人,做到数字人实时跟随脸捕特征的效果。奈何我也没有iphone手机😂,于是只好在网上寻找Android的替代方案,最终找到一个大佬修改的插件。

一、准备环境

1.配置环境

我这里使用的是:

UE4.27;

Android11手机;

facemoji.D.apk:安卓端的一款面部特征捕捉App;

QuickBridge:一款数字资产软件,UE5已集成到引擎;

2.下载资产

从上面的大佬的Github地址下载JSONLiveLink插件和facemoji.D App,如果上面地址失效了,可以从我的工程里下载。

下载好之后,插件直接丢项目目录Plugins目录下面,大佬的原插件是基于UE4.26制作的,我用UE4.27重新编译插件后可以直接使用,UE5没试过,笔记本太渣,跑不动UE5。App就直接装到手机上就好了。

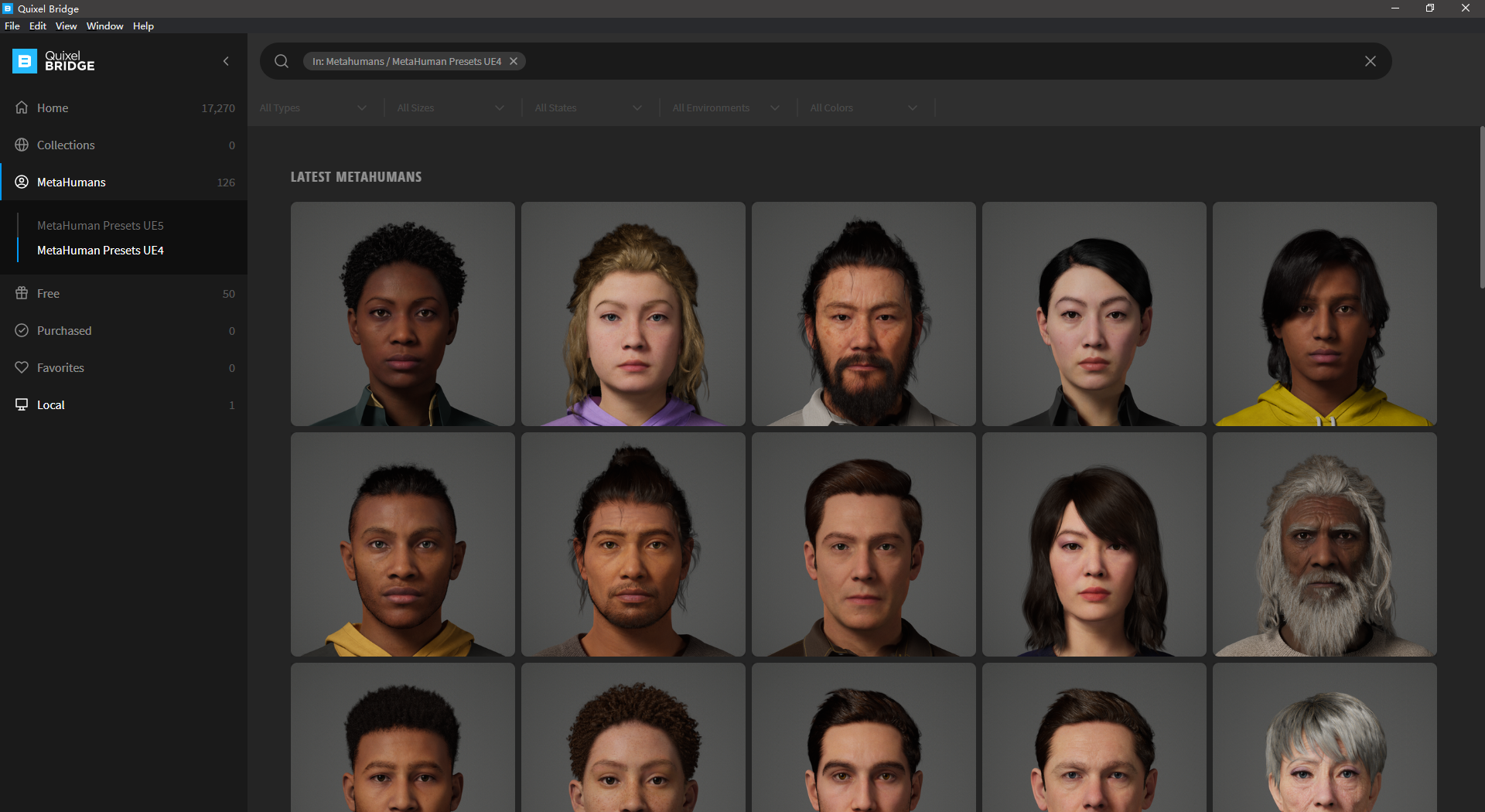

打开QuickBridge,这里可能需要科学上网,否则可能会很卡,直接进入MetaHumans/MetaHuman Presets UE4,随便挑个看得上眼的数字下载。

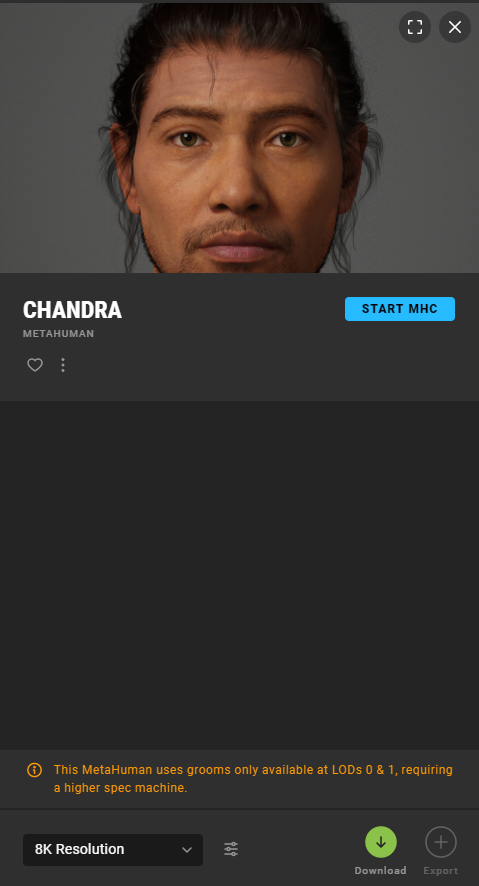

有的人物资产还完善,如:

挑一个完整的就好了,当然这个好像也没啥影响,也就LOD少一点。看网上说资产是有2K、4K、8K的,不知道为啥我的只能选8K,本来想搞个2K的就够了 ,8K的资产下载实在是太久了,反正我是晚上挂机挂了一晚上来下载的。

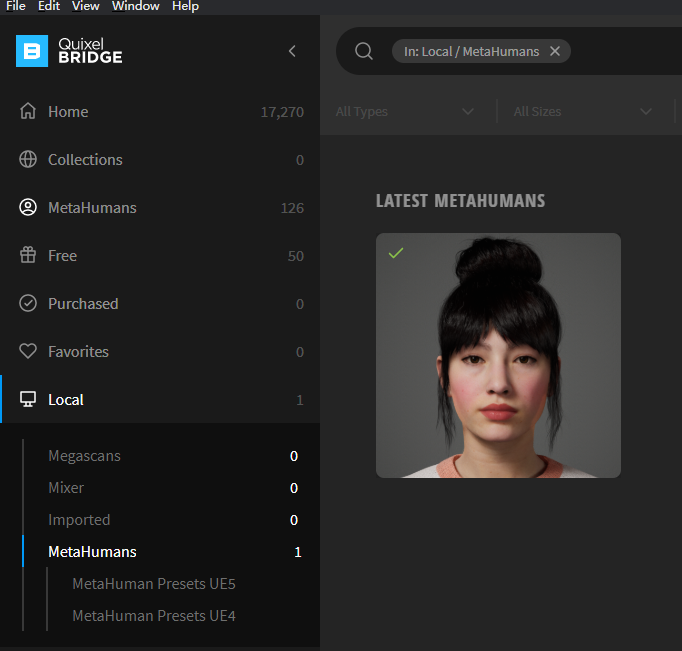

下载完之后在在Local/MetaHuman就可以看到我们下载好的数字人了。

3.导入资产

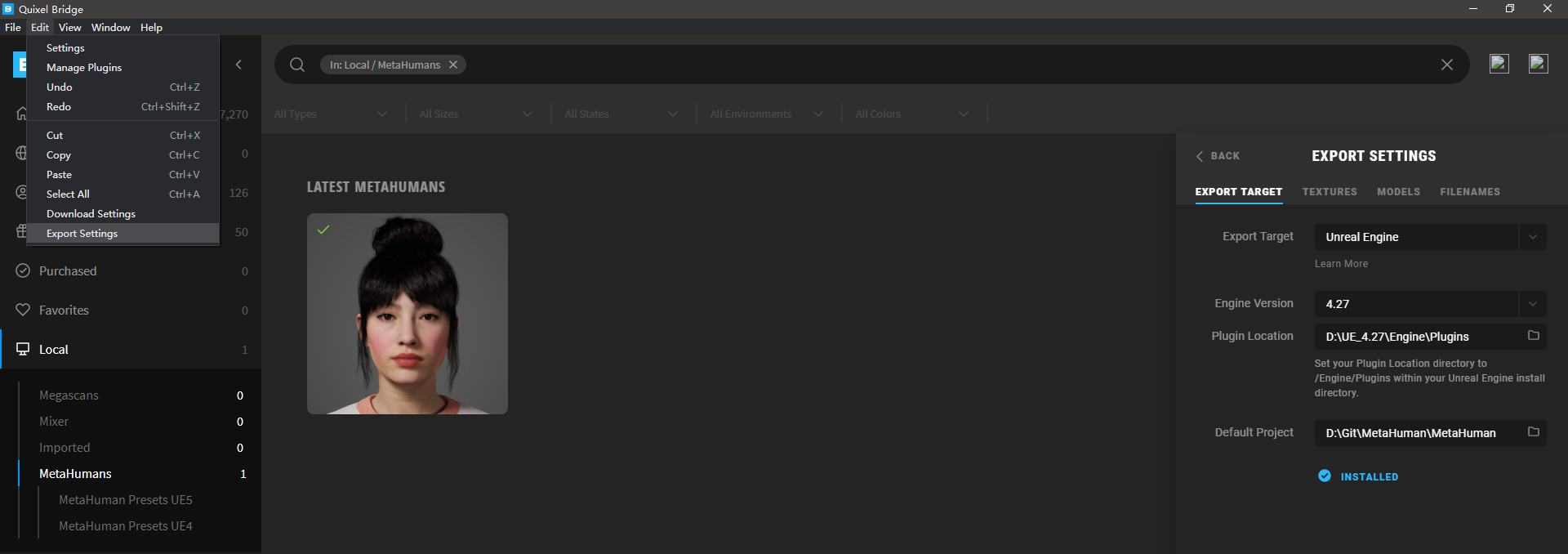

导入资产的时候,QuickBridge会提示我们要下载一个UE4插件,按提示下载就好了,我们也可以在Edit/Export Setting中设置导入配置

下载插件的时候需要关闭引擎,导入资产的时候需要打开引擎。接下来就是漫长的插件下载、资产导入和Shader编译了。

第一次导入数字人的时候会引擎会提示需要修改一些配置,全部按Enable missing就好了。

可以跟着官方的导入教程走。

二、UE4连接脸捕数据

1.接收脸捕数据

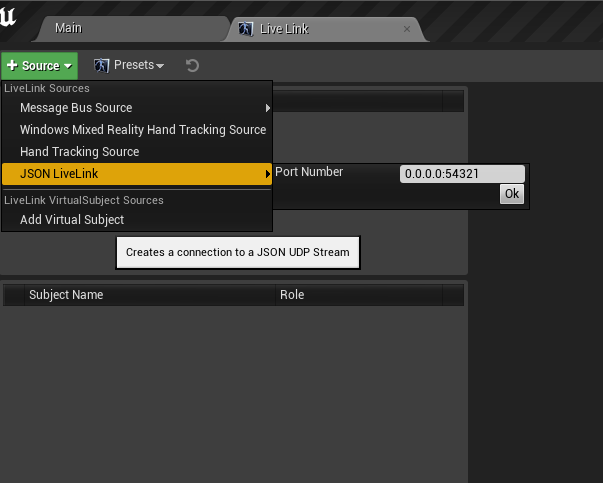

启动插件,我们就可以在Window/LiveLink窗口的Suorce中看到我们新加的插件了,点击OK就能创建一个数据源。

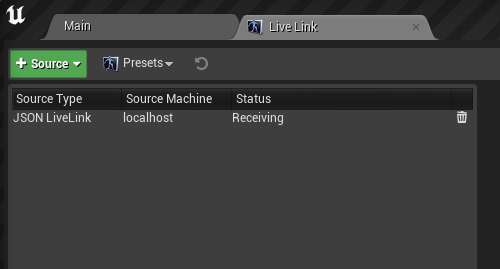

可以看到数据源已经处于数据接收的监听状态了。

然后关闭电脑的防火墙,一定要关闭防火墙,起初我就因为没有关闭防火墙导致手机一直连不上电脑ip,一度以为插件在UE4.27不行,后来一想会不会是防火墙把手机连接请求给拦截了,于是把防火墙关了,果然就连上了。

手机打开facemoji.D App,在最上面输入电脑端的IP,然后点击CONFIRM,这里手机和电脑一定要在一个局域网内,看UE的官方文档说,目前LiveLink还只支持局域网传输。

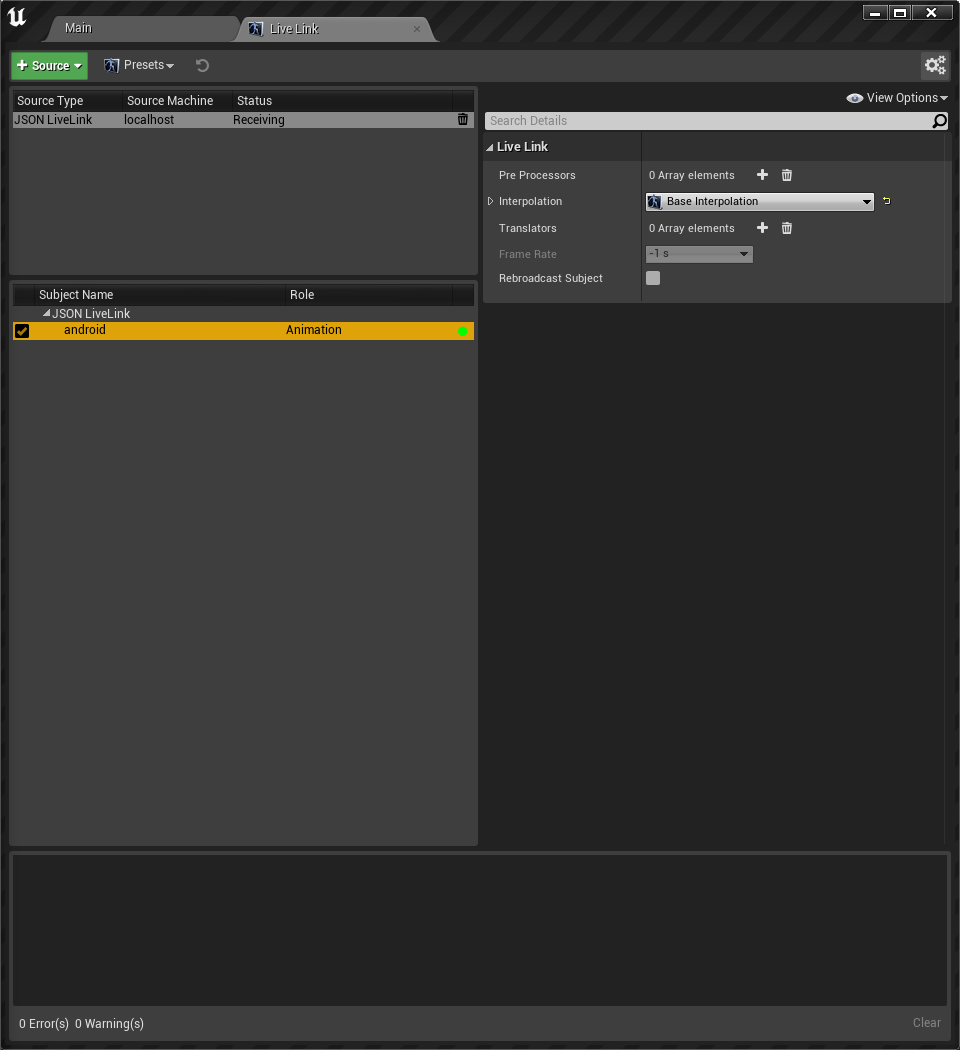

然后我们就可以看到在SubjectName下就多了一个Android源。

这时UE就已经从App接收到脸捕的数据了。绿色圆圈代表现在有数据传入,黄色圆圈代表没有数据传入。

2.将脸捕数据引用到数字人

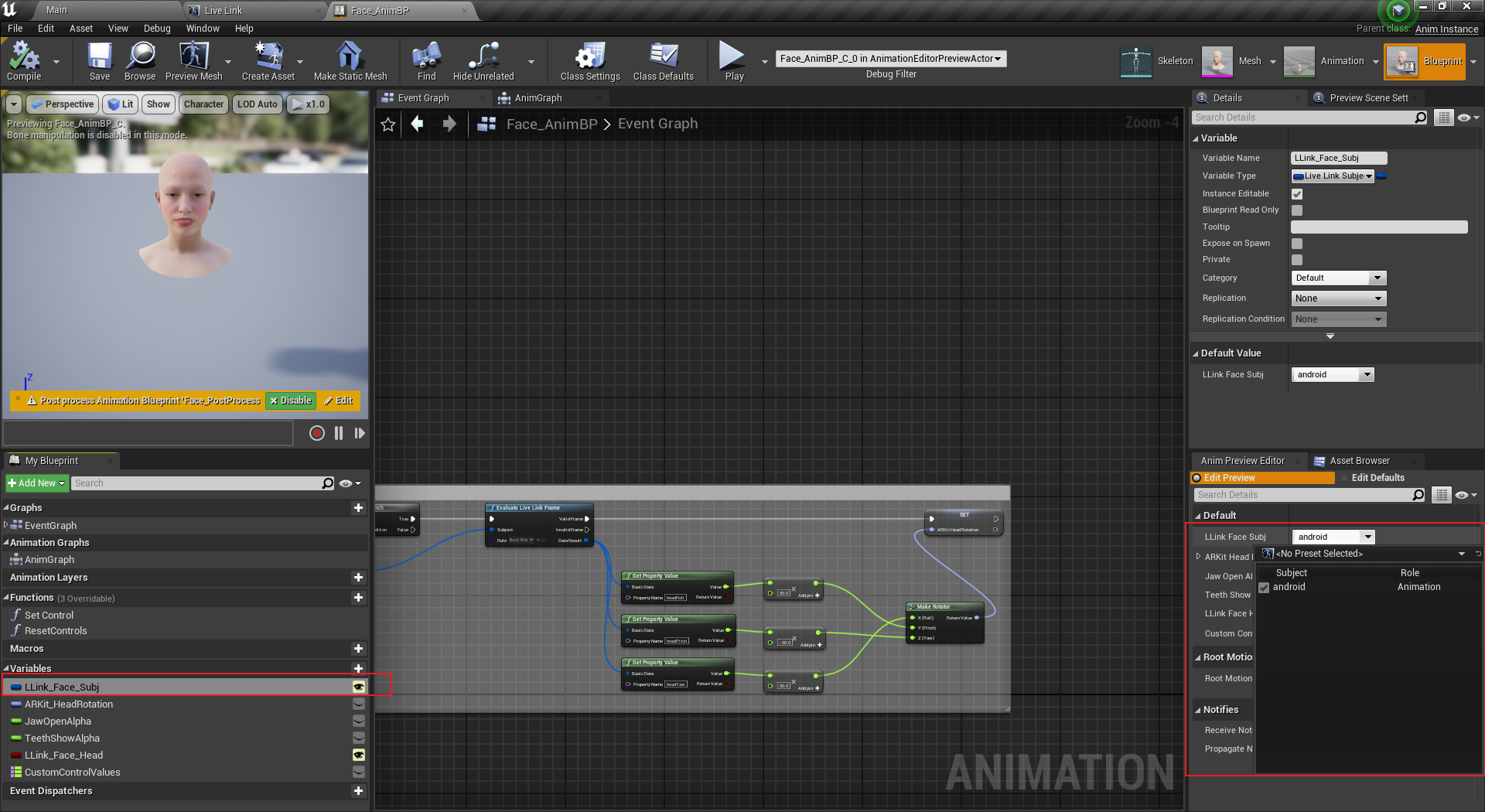

我们打开数字人的脸部动画蓝图Face_AnimBP,将LLink_Face_Subj变量的LLinkFaceSubj参数修改为我们自己的android源,这样脸捕数据就从手机传递到了动画蓝图中。当不同版本的数字人变量的名字可能不一样,找LiveLinckSubjectName类型的变量就好了。

然后我们来看一下效果:

手机录频画面就不放了😁。

这里有一点需要注意的是目前这个App有一个90s的时效,即单次连接时长超过90s就会断开,重启App,重新连接就可以再用90s,对于学习用的话90s已经够了。

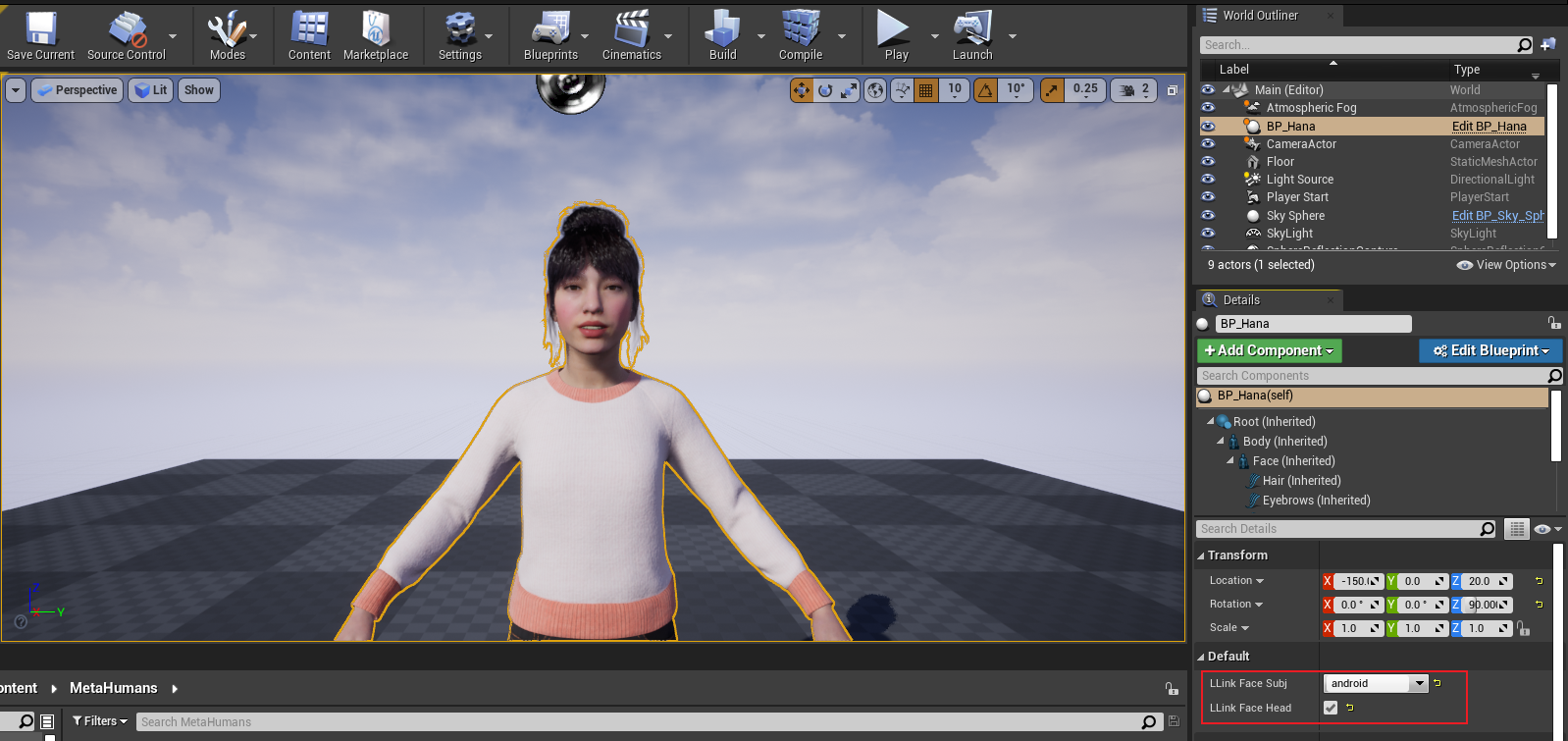

这时数据已经可以应用到动画蓝图了,但是还不能在运行时使用,这是因为角色蓝图中没有设置脸捕数据源,我们把角色拖入场景中,并设置好源,如果不设置角色蓝图在BeginPlay时会将一个空的数据源覆盖掉动画蓝图的数据源。

然后再运行,面捕数据就应用上了。